Robots.txt File In Hindi आज के इस आर्टिकल में हम जानेंगे कि Robots.txt फाइल क्या होती हैऔर इस फाइल के अंदर क्या-क्या चीज आती है यह फाइल हम कैसे बनाते हैंऔर इस फाइल को बनाने के लिए क्या हमें किसी tool की मदद चाहिए होती है या फिर इस फाइल को हम खुद ही बना लेते हैंऔर इस फाइल को बनाने से हमें क्या-क्या फायदे होते हैं इन सभी बातों को हम जानेंगे वह भी बहुत अच्छे से

अगर आपने कोई वेबसाइट बनाई है या फिर आप कोई वेबसाइट बनाने की सोच रही हो तो आपको एक बात ध्यान में रखनी है यह फाइल आपको बनानी ही पड़ेगी क्योंकि यह फाइल हर एक वेबसाइट के लिए बहुत ज्यादा जरूरी होती है क्योंकि इस फाइल को बनाने से ही गूगल को ये समझ में आता है कि आपकी वेबसाइट पर कौन-कौन से पेज गूगल को crawl करने हैं मतलब गूगल के Crawler को crawl करने हैं

Robots.txt In Hindi फाइल क्या है

Robots.txt File In Hindi जैसा आपको इस फाइल के नाम से ही पता चल रहा है यह फाइल हम गूगल के crawler के लिए बनाते हैं गूगल का crawler हमारी वेबसाइट पर जब आता है तो वह यह चीज चेक करता है कि आपकी वेबसाइट पर किन-किन पेज को crawl करना है इस फाइल के अंदर आप वह सारी इनफार्मेशन देते हो जिन पेज को आपको गूगल के अंदर इंडेक्स करवाना है और crawl करवाना हैऔर इसी फाइल के अंदरआप वह इनफॉरमेशन भी देते हो जिन pages को आपको crawl नहीं करवाना है या फिर इंडेक्स नहीं करवाना है तो एक बहुत जरूरी फाइल होती है हर एक वेबसाइट के लिए

Robots.txt के फायदे क्या है

अगर आप यह सोच रहे हो कि हम यह फाइल क्यों बनाते हैं इस फाइल को बनाने से क्या होता हैक्या इससे हमें कुछ फायदा मिलता भी है या नहीं तो मैं आपको कुछ फायदे बताता हूं इस फाइल को बनाने के

Crawling Control

जब आप Robots.txt इस फाइल को बनाते हो तो आप इस फाइल के अंदर वह सारे Rules लिखते हो जो आपकोअपनी वेबसाइट पर करवाने हैं तो इस फाइल के अंदर आप कुछ ऐसे Rules भी लगा सकते हो जिससे आपके कुछ इंपॉर्टेंट पेज है जिनको आप Crawl नहीं करवाना चाहते तो वह पेज Crawl नहीं होते हैं इसका मतलब यह है कि सर्च इंजन में वह पेज आपके नहीं देखेंगे अगर आप उन पेजों को दिखाना नहीं चाहते सर्च रिजल्ट में तो उसकी सेटिंग आपको इसी फाइल के अंदर करनी होती है

SEO benefit

अगर आप इस फाइल को अपलोड करते हो तो आपको सर्च इंजन ऑप्टिमाइजेशन में भी बहुत ज्यादा हेल्प मिलती है क्योंकि जब आप इस फाइल को अपलोड कर देते हो तो गूगल की जो बोर्ड्स होते हैं वह इस फाइल को रीड करते हैं और इस फाइल के रूल के हिसाब से ही आपकी वेबसाइट पर क्राउलिंग होती हैऔर जब तक गूगल के bots आपके पेज की क्रॉपिंग नहीं करते तब तक आपकी वेबसाइट गूगल में इंडेक्स नहीं होती है जिन पेज की क्राउलिंग हो जाती है उसी पेज को इंडेक्स किया जाता है

Crawl Budget

गूगल हर एक वेबसाइट को एक क्राउलिंग बजट देकर रखता है जिसके अंदर गूगल का bots हर वेबसाइट के ऊपर जाता है तो गूगल का bots यह ध्यान रखना है कि वह कितनी पेज को crawl करेगा और कितना टाइम वह एक वेबसाइट के ऊपर

लगाएगाअगरआपके कुछ पेज ऐसे हैं जिनको आप सर्च इंजन में नहीं दिखाना चाहते तो उनको आप इस फाइल के अंदर Disallow कर सकते हो जिससे यह जो आपका क्राउलिंग टाइम है वह उन पेज के ऊपर लगेगा जो पेज आपके इंपॉर्टेंट पेज है फालतू के पेज को crawl करने का टाइम बच जाएगा

Crawling क्या है

Crawlling का मतलब होता है कि जब गूगल का कोई bots आपकी वेबसाइट पर आता है तो वह आपकी वेबसाइट पर जो भी पेज है उनको स्कैन कर सके उन पेज को समझ सके वह पेज किस बारे में है क्योंकि जब तक गूगल के bots को आपका पेज समझ में नहीं आएगा तो वह उसको अपने डेटाबेस में इंडेक्स नहीं कर पाएगा अच्छे से इसलिए जितने अच्छे से आपके पेज की Crawlling होगी उतना ही

अच्छे से आपका पेज इंडेक्स होगाऔर इसके बाद गूगल के बोर्ड्स को आपका पेज अच्छे से समझ में आ जाएगा वह पेज किस बारे में हैऔर जब भी उसे पेज से रिलेटेड कोई भी व्यक्ति कहीं से भी search करेगा तो गूगल का बोर्ड्स आपके पेज को गूगल के रिजल्ट में दिखाएगा

Crawling के फायदे क्या है

आपके लिए क्रॉलिंग के फायदे जानना बहुत जरूरी है। अगर गूगल बॉट्स आपकी साइट को अच्छे से क्रॉल कर पाते हैं तो आपकी साइट गूगल में अच्छे से इंडेक्स होगी और गूगल आपकी साइट के स्ट्रक्चर को समझ पाएगा कि आपकी साइट में क्या-क्या जानकारी उपलब्ध है, जिसकी वजह से आपकी साइट की रैंकिंग भी अच्छी होती है क्योंकि जिस साइट को गूगल अच्छे से समझ लेता है, उस साइट को गूगल भी अच्छे से रैंक करता है।

Note: जब तक आपके पेज क्रॉल नहीं किए जाएंगे, तब तक वे पेज गूगल में इंडेक्स नहीं किए जाएंगे, इसलिए यदि आपका कोई पेज इंडेक्स नहीं हो रहा है, तो सबसे पहले यह जानना जरूरी है कि उन पेजों को क्रॉल किया गया है या नहीं।Robots.txt File In Hindi

Robots.txt file कैसे बनाते हैं (How to create robots.txt file)

Robots.txt File In Hindi मुझे पता है आप लोग यह जानने के लिए बहुत उत्साहित हैं कि robots.txt फ़ाइल कैसे बनाई जाती है, तो चलिए समझते हैं कि इस फ़ाइल को कैसे बनाया जाता है। इस फ़ाइल को बनाना बहुत ही आसान काम है, आपको बस यह काम करना है।

Open Notepad in your computer

इस फाइल को बनाने के लिए आपको अपने कंप्यूटर में नोटपैड खोलना होगा क्योंकि यह फाइल आपको खुद ही बनानी है, कोई और नहीं बनाता है। अगर आप इस फाइल को किसी टूल से बनाते हैं तो वह टूल इस फाइल में बहुत गड़बड़ कर सकता है, इसलिए इसे खुद ही बनाना बेहतर है।

Set Rules

नोटपैड ओपन करने के बाद यह नियम लगाने हैं कि कोनसे पेज आपकी साइट के इंडेक्स करने हैं या फिर क्रॉल करने हैं ये नियम आपको लगाना होता है अपने Robots.txt फाइल में कुछ पेज ऐसे होते हैं जिनको आप क्रॉल या फिर इंडेक्स नहीं करना चाहते हैं वो सभी नियम आपको इस फाइल में लगाने हैं

Save File name (robots.txt)

जब फ़ाइल पूरी हो जाए तो एक बात हमेशा याद रखें कि फ़ाइल को हमेशा robots.txt नाम से सेव करना चाहिए। अगर आप इसे किसी और नाम से सेव करके फ़ाइल अपलोड करते हैं तो हो सकता है कि आपकी फ़ाइल काम न करे क्योंकि अगर आप इसे robots.txt नाम से सेव करेंगे तभी गूगल bots आपकी साइट के पेजों को क्रॉल कर पाएंगे क्योंकि गूगल क्रॉलर सिर्फ़ robots.txt नाम वाली फ़ाइल को ही समझता है किसी और नाम को नहीं।

Robots.txt File Example

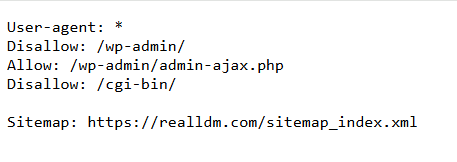

चलिए robots.txt फ़ाइल को एक उदाहरण से समझते हैं, इससे आपको यह और भी स्पष्ट हो जाएगा कि यह फ़ाइल किस तरह की है। मैं आपको अपनी खुद की वेबसाइट का उदाहरण दे रहा हूँ। मैंने भी अपनी वेबसाइट पर robots.txt फ़ाइल अपलोड की है।

तो ये है मेरी वेबसाइट की robots.txt फ़ाइल। मैंने इस फ़ाइल को नोटपैड में बनाया है। मैं आपको इस फ़ाइल में जो कुछ भी लिखा है उसे अच्छे से समझाता हूँ क्योंकि आपको भी अपनी वेबसाइट के लिए ऐसी ही फ़ाइल बनानी होगी। Robots.txt File In Hindi

- User-agent:* आपको एक बात का ध्यान रखना है कि जब भी आप robots.txt फाइल बनाये तो आपको शुरुआत में ये लाइन रखनी है क्योंकि ये लाइन बताती है कि आप जो भी नियम लागू करने जा रहे है वो सभी सर्च इंजन (google, yahoo, bing) के लिए एक जैसे होंगे

- Disallow: /wp-admin/ यह लाइन बताती है कि मैं अपने वर्डप्रेस एडमिन को क्रॉल करने की अनुमति नहीं दे रहा हूँ। मैं नहीं चाहता कि Google bots मेरे wp-admin को क्रॉल करें। अगर आप वर्डप्रेस का इस्तेमाल कर रहे हैं तो आपको भी यही करना होगा।

- Allow: /wp-admin/admin-ajax.php हमें यह नियम अपनी robots.txt फ़ाइल में डालना होगा, इससे यह सुनिश्चित होता है कि जब कोई उपयोगकर्ता हमारे पेज पर आएगा, तो वह उपयोगकर्ता हमारे पेज पर मौजूद हर चीज़ का सही तरीके से उपयोग कर सकेगा, जैसे कोई बटन या लिंक।

- Disallow: /cgi-bin/ मैंने इस फ़ाइल को Disallow कर दिया है क्योंकि मैं नहीं चाहता कि मेरी यह फ़ाइल कोई देखे क्योंकि इस फ़ाइल में मेरी कुछ महत्वपूर्ण जानकारी है जिसे मैं क्रॉल नहीं करना चाहता।

- Sitemap: https://realldm.com/sitemap_index.xml मैंने इस फ़ाइल में अपनी वेबसाइट का URL दिया है क्योंकि अगर हम robots.tst फ़ाइल में साइटमैप का URL जोड़ते हैं तो Google बॉट्स के लिए यह आसान हो जाता है

मुझे पता है कि आपके मन में ये सवाल जरूर आ रहा होगा कि आखिर हम ये सारी जानकारी अपने नोटपैड में कहां से लिखेंगे, तो चलिए मैं आपको बताता हूं कि आप ये जानकारी अपनी फाइल में कहां कहां से लिखेंगे

User-agent:* आपको इसे ऐसे ही लिखना है, कहीं से कुछ कॉपी मत करना, बस अपने लैपटॉप या कंप्यूटर से same टाइप करना है

Disallow: /wp-admin/ इसको भी ऐसे ही लिखना है क्योंकि अगर आप ये लाइन लिखते हैं तो इसका मतलब है कि क्रॉलर आपके वर्डप्रेस एडमिन में कुछ नहीं कर सकता है, क्रॉलर को वहां जाने की इजाजत नहीं है

Allow: /wp-admin/admin-ajax.php आपको ये लाइन ऐसे ही लिखनी है, आपको इसे कहीं से कॉपी नहीं करना है बल्कि आपको ये लाइन सही से लिखनी है, मतलब कुछ भी छूटना नहीं चाहिए

Disallow: /cgi-bin/ यह पंक्ति भी उसी प्रकार लिखी जानी चाहिए क्योंकि सभी होस्टिंग प्रदाता यह पंक्ति Disallow: /cgi-bin/ उपलब्ध नहीं कराते हैं, इसलिए आपको यह Line स्वयं अपनी robots.txt फ़ाइल में लिखनी होगी।

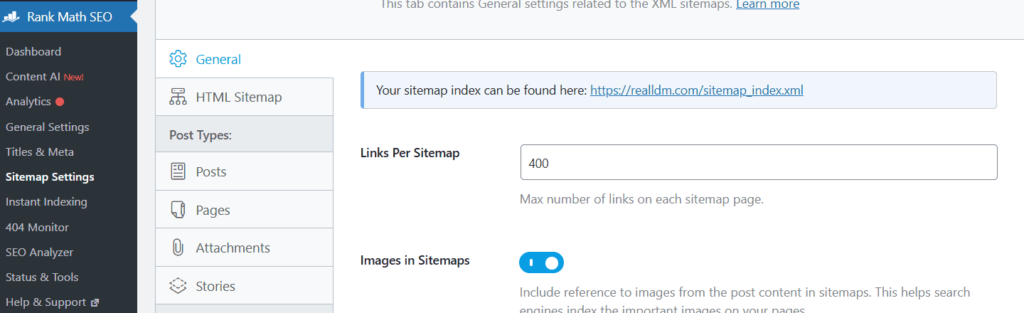

Sitemap: https://realldm.com/sitemap_index.xml इसे ऐसे समझिए, इस लाइन को कहां से कॉपी करना है। इस लाइन के लिए आपको वर्डप्रेस में SEO प्लगइन में जाना होगा। आप जो भी ऐप इस्तेमाल कर रहे हैं, चाहे वो Rankmath हो या Yoast SEO, इनमें आपको ऑप्शन मिलेगा, सेटिंग्स में जाकर साइटमैप खोलें और वहां से URL कॉपी करें।

Rankmath मैं साइटमैप की सेटिंग

Open Rankmath Plugin : सबसे पहले आपको Rankmath प्लगइन में जाना है उसे प्लगइन में जाने के बाद आपको उसके अंदर एक ऑप्शन मिलता है साइड मैप सेटिंग करके उसे पर आपको क्लिक करना है जैसे ही आप उसे पर क्लिक करोगे आपके सामने आपकी वेबसाइट का साइड में आ जाएगा

जैसा आप देख सकते हो कि इस प्लगइन ने मेरा साइड में अपने आप ही बना लिया हैऔर इसके अंदर मेरा साइड में देखना बहुत ही आसान है जब आप इन Plugin को इंस्टॉल करते हो अपनी वेबसाइट के अंदर तो यह प्लगइन आपकी वेबसाइट का साइड map खुद ही बना लेते हैं अपने पास से

Robots.txt File इसे कहां अपलोड करें

आप समझ गए होंगे कि robots.txt फ़ाइल क्या है और इसे कैसे बनाया जाता है लेकिन आपको यह भी पता होना चाहिए कि इस फ़ाइल को कहाँ अपलोड करना है। अगर आप इस फ़ाइल को सही जगह पर अपलोड नहीं करेंगे तो आपकी फ़ाइल सबमिट नहीं होगी।

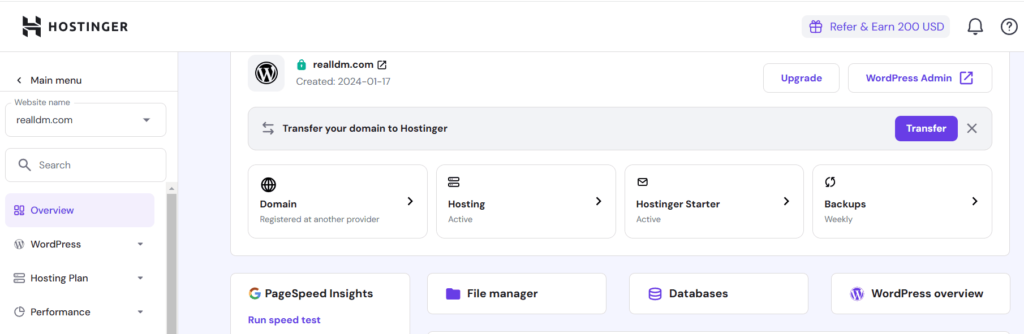

Go to Hosting

एक बारी अगर आपकी यह फाइल बन जाए तो उसके बाद आपको अपने होस्टिंग पैनल में जाना है जहां से भी अपने होस्टिंग ले रखी है क्योंकि यह फाइल आपकी होस्टिंग पैनल में ही अपलोड होगी तो इसलिए सबसे पहले आपको अपने होस्टिंग पैनल में जाना है जहां से भी अपने होस्टिंग ली है

File Manager

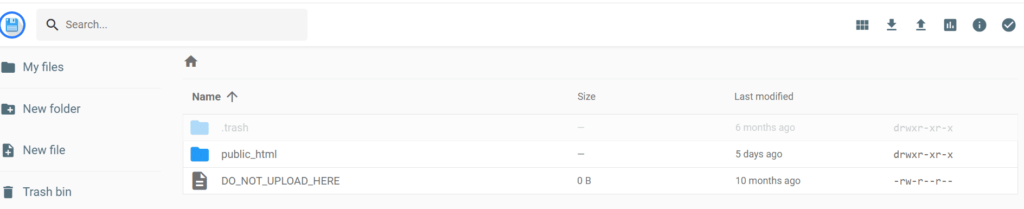

आपको अपनी होस्टिंग के फाइल मैनेजर में जाना है और इस फाइल मैनेजर में जाने के बाद आपको एक ऑप्शन देखने को मिलता है Public html उसे पर आपको क्लिक करना है और उसे पर क्लिक करने के बादआपको यह फाइल Public html के अंदर अपलोड कर देनी है

मैं Hostinger का होस्टिंग इस्तेमाल कर रहा हूंआप सामने देख सकते हो एक आपको ऑप्शन दिख रहा होगा फाइल मैनेजर करके आपको भी ऐसे ही ऑप्शन दिखेगा अगर आप यही होस्टिंग का इस्तेमाल कर रहे हो तोअगर आप दूसरी होस्टिंग का इस्तेमाल कर रहे हो तब भी आपके सामने यह ऑप्शन आता है फाइल मैनेजर का

जैसे ही आप फाइल मैनेजर पर क्लिक करते हो उसके बाद आपके सामने यह स्क्रीन आ जाती हैऔर इसके अंदर आपको एक ऑप्शन दिख रहा होगा Public html करके इसके ऊपर आपको क्लिक करना है इसके ऊपर जैसे ही आप क्लिक करोगे तो इसके अंदर वह फाइल अपलोड करनी है आपको जो फाइल आपने बनाई है अपने नोटपैड के अंदर जिसका नाम है Robots.txt file

अपलोड करने के बाद आपको दो बातों का ध्यान रखना है आपको यह देखना है कि आपकी जो फाइल का नाम है वह सही है या नहींऔर दूसरा इस बात का ध्यान रखना है अपलोड करने के बाद सैफ चेंज पर क्लिक जरूर करना है क्योंकि तभी वह आपकी फाइल अपलोड मानी जाएगी Robots.txt File In Hindi

Robots.txt File In Hindi FAQ

Question:1 robots.txt फाइल कहां है?

Answer: अगर आपको यह फाइल अपनी देखनी है तो इस फाइल को देखने के दो तरीके मैं आपको बताने जा रहा हूं

1.Go to wordpress SEO Plugin : अगर आप वर्डप्रेस इस्तेमाल कर रहे हो और वर्ल्ड प्रेस के साथ-साथ ही आप कोई प्लगिंस को इस्तेमाल कर ही रहे होंगे सर्च इंजन ऑप्टिमाइजेशन करने के लिएआपको क्या करना है आप जो भी प्लगइन का इस्तेमाल कर रहे हो Like Rankmath and Yoast SEO सर्च इंजन ऑप्टिमाइजेशन करने के लिए उसे प्लगइन के अंदर आपको जाना है उसकी सेटिंग्स में जाना है सेटिंग्स में जाने के बाद आपको एक ऑप्शन मिलता है Robots.txt फाइल काआप वहां पर यह फाइल देख सकते हो

2.दूसरा जो तरीका मैं आपको बता रहा हूं ये बहुत ही आसान तरीका हैआप इस फाइल को देख सकते हो बहुत ही आसानी से बस आपकोसर्च बार में यह लिखना है जो मैं लिखने जा रहा हूं (realldm.com/robots.txt)

आपको अपनी वेबसाइट का नाम सर्च बार में लिखना है डोमेन के साथ उसके बाद आपको Robots.txt फाइल लिखना है और Enter कर देना हैआपकी फाइल आपके सामने आ जाएगी

Question:2 robots.txt को HTML में कैसे शामिल करें?

Answer: इसके लिए मैंने आपको बहुत ही ज्यादा आसानी से बताया है आपको अपने कंप्यूटर या लैपटॉप के अंदर नोटपैड ओपन करना है और उसके अंदर आपको यह File के Rules लिखने हैं सभी और उसी के अंदर आपको यह फाइल को सेव करना है जब आप होस्टिंग में जाओगे तो वहां पर जाकर आपको सीधा यह फाइल अपलोड कर देनी है और कुछ नहीं करना

Question:3 SEO में robots.txt फ़ाइल का उद्देश्य क्या है?

Answer: सर्च इंजन ऑप्टिमाइजेशन मे इस फ़ाइल का महत्व बहुत ज्यादा है मैंने आपको बता ही दिया है कि अगर आप इस फाइल को अपलोड करते हो अपनी वेब डायरेक्टरी में जाकर तो इससे गूगल के bots को यह पता चलता है कि आपकी वेबसाइट पर किन पेज को crawl करना हैऔर जिन पेज की क्राउलिंग होती है उन्हीं को इंडेक्स किया जाता है जब तक पेज इंडेक्स नहीं होंगे तब तक गूगल में आपकी रैंकिंग नहीं आएगी तो इसीलिए सर्च इंजन ऑप्टिमाइजेशन का बहुत ज्यादा महत्व है इस फाइल के अंदर

Last word

Robots.txt File In Hindi मैंने आपको हर चीज बता दी है इस फाइल के बारे में यह फाइल क्या होती है कैसे बनाना है क्या-क्या इसका फायदा होता है मुझे उम्मीद है यह आर्टिकल आपको पसंद आया होगा अगर आपको कुछ पूछना है तो आप मुझे कमेंट कर सकते हो मैं आपको जल्दी रिप्लाई दूंगा Robots.txt File In Hindi

Hello friends! My name is Jaanu and I am a resident of Delhi. I like to do digital work and my interest is more in the digital area, like SEO, digital marketing, and social media marketing. I write articles on all these and I hope you will like my articles.